El término «GZIP» se refiere a un método de compresión de datos ampliamente utilizado en la informática para reducir el tamaño de archivos y datos para su almacenamiento o transmisión más eficiente. La compresión GZIP es particularmente común en entornos web, donde se utiliza para comprimir archivos de texto, como HTML, CSS, JavaScript y otros recursos, con el fin de acelerar la carga de páginas web y reducir el consumo de ancho de banda.

La compresión GZIP se basa en un algoritmo de compresión sin pérdida desarrollado por Jean-Loup Gailly y Mark Adler. Este algoritmo busca patrones repetitivos en los datos y los reemplaza por códigos más cortos, lo que resulta en una representación más compacta del mismo contenido. A diferencia de la compresión con pérdida, como la utilizada en formatos de imagen como JPEG, la compresión GZIP conserva todos los datos originales y permite una recuperación exacta del contenido original después de descomprimirlo.

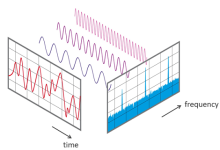

El proceso de compresión GZIP implica varios pasos. Primero, los datos se dividen en bloques de un tamaño específico. Luego, se utiliza el algoritmo de compresión DEFLATE, que forma la base del formato GZIP, para comprimir cada bloque de datos de forma individual. DEFLATE utiliza una combinación de algoritmos de codificación de longitud de cadena (LZ77) y codificación de Huffman para lograr la compresión. LZ77 identifica y reemplaza secuencias repetitivas de datos, mientras que la codificación de Huffman asigna códigos de longitud variable a los símbolos de entrada, lo que permite representar los datos más comunes con menos bits.

Una vez que todos los bloques de datos han sido comprimidos, se crea un encabezado GZIP que contiene información sobre el archivo original, como su tamaño y tipo de contenido. Este encabezado también incluye un checksum para verificar la integridad de los datos durante la descompresión. Finalmente, todos los bloques comprimidos y el encabezado se concatenan en un solo flujo de datos que constituye el archivo GZIP comprimido.

Cuando un cliente solicita un recurso web que está comprimido con GZIP, el servidor web verifica si el cliente admite la compresión GZIP mediante la revisión de las cabeceras de la solicitud HTTP. Si el cliente es compatible, el servidor comprime el recurso antes de enviarlo al cliente, lo que resulta en una transferencia más rápida de datos a través de la red. El cliente luego descomprime el recurso antes de procesarlo o mostrarlo al usuario final.

La compresión GZIP es especialmente beneficiosa en entornos web, donde puede reducir significativamente el tiempo de carga de las páginas y mejorar la experiencia del usuario al hacer que el contenido se cargue más rápido. Además, también puede ayudar a reducir los costos de ancho de banda para los propietarios de sitios web al disminuir la cantidad de datos transferidos.

En resumen, la compresión GZIP es una técnica eficaz para reducir el tamaño de archivos y datos en entornos informáticos, especialmente en la web, donde puede mejorar el rendimiento y la eficiencia de la transferencia de datos. Su implementación generalizada ha contribuido a una mejor experiencia de usuario y a una reducción en los costos de ancho de banda para los sitios web y servicios en línea.

Más Informaciones

La compresión GZIP, como se mencionó anteriormente, se basa en el algoritmo DEFLATE, que a su vez utiliza una combinación de dos técnicas principales: la codificación de longitud de cadena (LZ77) y la codificación de Huffman. Estos algoritmos trabajan en conjunto para encontrar y eliminar redundancias en los datos, lo que resulta en una representación más compacta y eficiente.

El algoritmo LZ77, desarrollado por Abraham Lempel y Jacob Ziv en 1977, es un método de compresión sin pérdida que identifica secuencias repetitivas de datos y las reemplaza por referencias a instancias anteriores de esas secuencias. Por ejemplo, si un fragmento de texto contiene la palabra «computadora» varias veces, el algoritmo LZ77 solo almacenaría la palabra una vez y luego haría referencia a ella en cada ocurrencia subsiguiente. Esto reduce la cantidad de datos necesarios para almacenar la información sin perder ningún detalle.

La codificación de Huffman, inventada por David A. Huffman en 1952, es un método de compresión de datos que asigna códigos de longitud variable a cada símbolo en función de su frecuencia de aparición en los datos originales. Los símbolos más comunes reciben códigos más cortos, mientras que los menos comunes reciben códigos más largos. Esto permite representar los datos más eficientemente, ya que los símbolos más frecuentes se representan con menos bits, lo que resulta en una compresión más efectiva.

El algoritmo DEFLATE, que combina LZ77 y la codificación de Huffman, utiliza LZ77 para encontrar repeticiones de datos dentro de una ventana deslizante y luego utiliza la codificación de Huffman para representar estas repeticiones de manera eficiente. Este enfoque híbrido permite una compresión más efectiva que cualquiera de los dos algoritmos por sí solos.

Además de su eficacia en la compresión de datos, la compresión GZIP también es compatible con la descompresión en tiempo real, lo que significa que los datos comprimidos se pueden descomprimir mientras se transfieren, sin necesidad de esperar a que se complete la descarga completa. Esto es especialmente útil en entornos web, donde los navegadores modernos son capaces de descomprimir los recursos GZIP automáticamente durante la carga de la página.

En términos de implementación, la compresión GZIP se puede configurar en servidores web para comprimir automáticamente ciertos tipos de archivos antes de enviarlos a los clientes. Esto se hace generalmente mediante la configuración del servidor para incluir la cabecera «Content-Encoding: gzip» en las respuestas HTTP, lo que indica a los navegadores que el contenido está comprimido con GZIP y debe ser descomprimido antes de su procesamiento.

En resumen, la compresión GZIP es una técnica efectiva y ampliamente utilizada para reducir el tamaño de archivos y datos en entornos informáticos, con aplicaciones especialmente significativas en el ámbito de la web. Su implementación se basa en algoritmos de compresión sin pérdida como LZ77 y la codificación de Huffman, y su compatibilidad con la descompresión en tiempo real la hace ideal para mejorar el rendimiento y la eficiencia de la transferencia de datos en línea.