El análisis del tiempo de ejecución de las operaciones realizadas mediante el uso de matrices es un tema fundamental en el campo de la informática y la ciencia de la computación. Este análisis se vuelve especialmente relevante al considerar la eficiencia de algoritmos y estructuras de datos que hacen uso intensivo de matrices, como puede ser el caso de las operaciones con matrices en álgebra lineal, el procesamiento de imágenes, la simulación numérica y muchos otros campos.

Cuando nos referimos al tiempo de ejecución de las operaciones con matrices, estamos interesados principalmente en comprender cuánto tiempo tarda un algoritmo en completar una determinada tarea en función del tamaño de las matrices involucradas. Esto se expresa típicamente en términos de la notación de complejidad computacional, que proporciona una forma de describir cuánto tiempo y recursos computacionales requiere un algoritmo a medida que aumenta el tamaño de los datos de entrada.

La solución definitiva para acortar enlaces y gestionar tus campañas digitales de manera profesional.

• Acortamiento de enlaces instantáneo y rápido

• Páginas de perfil interactivas

• Códigos QR profesionales

• Análisis detallados de tu rendimiento digital

• ¡Y muchas más funciones gratuitas!

Una de las operaciones fundamentales que se realiza con matrices es la multiplicación. La multiplicación de matrices es una operación que combina filas y columnas de las matrices de entrada para producir una nueva matriz como resultado. La complejidad temporal de la multiplicación de matrices puede variar dependiendo del algoritmo utilizado y de las propiedades de las matrices involucradas.

Uno de los algoritmos más comunes para la multiplicación de matrices es el algoritmo estándar, que consiste en calcular cada elemento de la matriz resultante como la suma de los productos de los elementos correspondientes de las filas de la primera matriz y las columnas de la segunda matriz. Para matrices de tamaño n×n, este algoritmo tiene una complejidad temporal de O(n3).

Sin embargo, existen algoritmos más eficientes para la multiplicación de matrices, como el algoritmo de Strassen, que reduce la complejidad temporal a aproximadamente O(n2.81). Este algoritmo aprovecha la propiedad de que la multiplicación de matrices se puede descomponer en operaciones más pequeñas y combinar de manera eficiente los resultados parciales para obtener el resultado final. Aunque el algoritmo de Strassen es más eficiente en términos asintóticos, en la práctica puede ser superado por el algoritmo estándar debido a sus mayores constantes ocultas y a la complejidad de implementación.

Además de la multiplicación de matrices, otras operaciones comunes que se realizan con matrices incluyen la suma, la resta, la transposición y la inversión. Cada una de estas operaciones puede tener su propio tiempo de ejecución dependiendo del algoritmo utilizado y de las propiedades de las matrices involucradas.

Es importante destacar que el tiempo de ejecución de las operaciones con matrices puede variar significativamente dependiendo de diversos factores, como la implementación específica del algoritmo, las características del hardware subyacente, el tamaño y la densidad de las matrices, y la eficiencia de la gestión de la memoria. Por lo tanto, es crucial realizar un análisis detallado del tiempo de ejecución en el contexto de la aplicación específica en la que se utilizan las matrices, así como realizar pruebas empíricas para evaluar el rendimiento en condiciones reales.

En resumen, el análisis del tiempo de ejecución de las operaciones con matrices es un aspecto fundamental en el diseño y la optimización de algoritmos y estructuras de datos en una variedad de campos de la informática y la ciencia de la computación. Comprender la complejidad temporal de estas operaciones es esencial para tomar decisiones informadas sobre la selección y el diseño de algoritmos en función de los requisitos de rendimiento de una aplicación específica.

Más Informaciones

Claro, profundicemos en el análisis del tiempo de ejecución de las operaciones con matrices y exploremos algunos de los algoritmos específicos utilizados en este contexto, así como sus implicaciones en diferentes aplicaciones.

Como mencioné anteriormente, una de las operaciones más comunes con matrices es la multiplicación. Esta operación es fundamental en una variedad de campos, desde el procesamiento de imágenes hasta la simulación numérica y el aprendizaje automático. La multiplicación de matrices puede ser costosa computacionalmente, especialmente cuando se trata de matrices grandes.

El algoritmo estándar para la multiplicación de matrices, también conocido como el método de multiplicación de celdas, implica calcular cada elemento de la matriz resultante como la suma de los productos de los elementos correspondientes de las filas de la primera matriz y las columnas de la segunda matriz. Aunque este enfoque es sencillo y fácil de entender, su complejidad temporal es O(n3), donde n es el tamaño de las matrices.

Para matrices de gran tamaño, esta complejidad puede resultar prohibitiva en términos de tiempo de ejecución. Es por eso que se han desarrollado algoritmos más eficientes, como el algoritmo de Strassen mencionado anteriormente. El algoritmo de Strassen divide las matrices de entrada en submatrices más pequeñas y realiza operaciones recursivas para calcular el producto de estas submatrices. Luego, combina los resultados parciales para obtener la matriz resultante. Aunque el algoritmo de Strassen reduce la complejidad temporal a aproximadamente O(n2.81), en la práctica puede ser superado por el algoritmo estándar debido a las constantes ocultas y la complejidad de implementación.

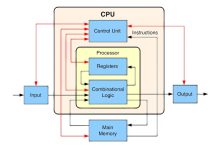

Otro enfoque para mejorar la eficiencia de la multiplicación de matrices es el uso de técnicas de optimización de hardware y software. Por ejemplo, los procesadores modernos a menudo tienen conjuntos de instrucciones especializadas para operaciones matriciales, como SIMD (Single Instruction, Multiple Data), que pueden acelerar significativamente el cálculo de matrices mediante la realización de múltiples operaciones en paralelo.

Además de la multiplicación de matrices, otras operaciones comunes, como la suma, la resta, la transposición y la inversión, también tienen implicaciones importantes en términos de tiempo de ejecución. Por ejemplo, la inversión de una matriz suele ser una operación costosa computacionalmente, especialmente para matrices grandes. Se han desarrollado diversos algoritmos para calcular la inversa de una matriz, como el método de eliminación gaussiana y el método de factorización LU, cada uno con su propia complejidad temporal y aplicabilidad en diferentes contextos.

Es crucial tener en cuenta que el rendimiento de las operaciones con matrices puede variar significativamente según el hardware subyacente y la implementación específica del algoritmo. Por lo tanto, es importante realizar pruebas empíricas y ajustes de rendimiento para optimizar el tiempo de ejecución en el contexto de la aplicación específica en la que se utilizan las matrices.

En resumen, el análisis del tiempo de ejecución de las operaciones con matrices es un área fundamental en la ciencia de la computación y la ingeniería de software. Comprender la complejidad temporal de estas operaciones y seleccionar los algoritmos adecuados es esencial para garantizar el rendimiento óptimo en una amplia gama de aplicaciones.